Inicio »TI» Diferencia entre Unicode y ASCII (con tabla)

Diferencia entre Unicode y ASCII (con tabla)

Unicode y ASCII son los estándares de codificación de caracteres que se utilizan principalmente en el sector de TI. Unicode es el estándar de tecnología de la información que se utiliza para codificar, representar y manejar textos en los sistemas de escritura, mientras que ASCII (Código estándar americano para el intercambio de información) representa texto en computadoras como símbolos, dígitos, letras mayúsculas y minúsculas.

Representan texto para los dispositivos de telecomunicaciones y computadoras. ASCII codifica solo varias letras, números y símbolos, mientras que Unicode codifica una gran cantidad de caracteres.

los La diferencia entre Unicode y ASCII es que Unicode es el estándar de TI que representa letras de inglés, árabe, griego (y muchos más idiomas), símbolos matemáticos, escrituras históricas, etc., mientras que ASCII está limitado a pocos caracteres, como letras mayúsculas y minúsculas, símbolos y dígitos (0- 9).

Unicode puede denominarse superconjunto de ASCII porque codifica más caracteres que ASCII. El último término generalmente funciona convirtiendo los caracteres en números porque es más fácil para la computadora almacenar números que alfabetos.

Tabla de comparación entre Unicode y ASCII (en forma tabular)

| Definición | Unicode es el estándar de TI que codifica, representa y maneja texto para computadoras, dispositivos de telecomunicaciones y otros equipos. | ASCII es el estándar de TI que codifica los caracteres solo para comunicaciones electrónicas. |

| Abreviatura | Unicode también se conoce como juego de caracteres universal. | El Código Estándar Americano para el Intercambio de Información es la forma completa de ASCII. |

| Función | Unicode representa una gran cantidad de caracteres como letras de varios idiomas, símbolos matemáticos, escrituras históricas, etc. | ASCII representa un número específico de caracteres, como letras mayúsculas y minúsculas del idioma inglés, dígitos y símbolos. |

| Utiliza | Utiliza 8 bits, 16 bits o 32 bits para presentar cualquier carácter y ASCII está subordinado a Unicode. | Utiliza 7 bits para presentar cualquier personaje. Lo hace convirtiendo los caracteres en números. |

| Espacio ocupado | Unicode admite una gran cantidad de caracteres y ocupa más espacio. | ASCII solo admite 128 caracteres y ocupa menos espacio. |

¿Qué es Unicode?

Unicode es el estándar de TI que se utiliza para codificar, representar y manejar el texto de las computadoras, dispositivos de telecomunicaciones y otros equipos. Es mantenido por Unicode Consortium y es sinónimo de Universal Character Set.

Codifica una amplia gama de caracteres como textos en varios idiomas (también los textos bidireccionales como el del hebreo y el árabe que tiene escrituras de derecha a izquierda), símbolos matemáticos, escrituras históricas y muchas cosas más.

Unicode operaba tres tipos de codificaciones, a saber, UTF-8, UTF-16 y UTF-32 que usaban 8 bits, 6 bits y 32 bits respectivamente. Se ha utilizado ampliamente en tecnologías recientes como lenguajes de programación (Java, etc.) y sistemas operativos modernos.

Unicode admite una gran cantidad de caracteres y ocupa más espacio en un dispositivo, por lo que ASCII forma parte de Unicode. El ASCII es válido en UTF-8 que contiene 128 caracteres.

¿Qué es ASCII?

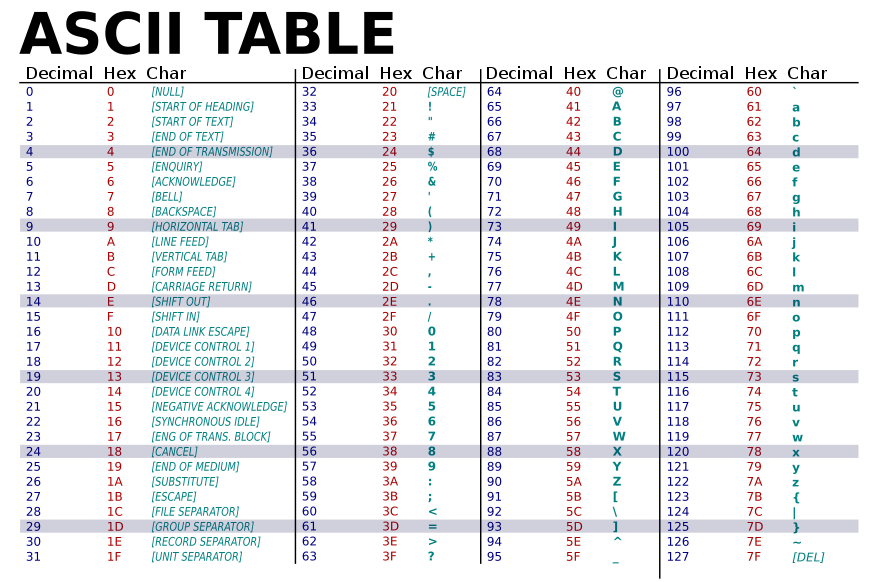

ASCII es el estándar de codificación que se utiliza para la codificación de caracteres en las comunicaciones electrónicas. Se utiliza principalmente para la codificación de los alfabetos ingleses, las letras minúsculas (az), las letras mayúsculas (AZ), los símbolos como los signos de puntuación y los dígitos (0-9).

El Código Estándar Americano para el Intercambio de Información o ASCII codifica 128 caracteres predominantemente en el idioma inglés que se utilizan en las computadoras y la programación modernas.

ASCII utiliza 7 bits de los datos para codificar cualquier carácter y, por lo tanto, ocupa menos espacio. ASCII se utilizó en gran medida para la codificación de caracteres en la World Wide Web y todavía se utiliza para programas informáticos modernos como HTML.

ASCII codifica cualquier texto convirtiéndolo en números porque el conjunto de números es más fácil de almacenar en la memoria de la computadora que los alfabetos como idioma. En términos generales, este proceso en sí mismo se llama codificación.

Principales diferencias entre Unicode y ASCII

- Unicode es el estándar de TI que codifica, representa y maneja el texto en las computadoras, mientras que ASCII es el estándar que codifica el texto (predominantemente inglés) para comunicaciones electrónicas.

- Unicode es la abreviatura de Universal Character Set, mientras que ASCII significa American Standard Code for Information Interchange.

- Ambos términos difieren entre sí en el contexto de la función. Unicode es el estándar de codificación que codifica una gran cantidad de caracteres como textos y alfabetos de otros idiomas (incluso textos bidireccionales), símbolos, escrituras históricas mientras que ASCII codifica los alfabetos del idioma inglés, mayúsculas y minúsculas, símbolos, etc. .

- Unicode usó 8 bits, 16 bits o 32 bits para codificar una gran cantidad de caracteres, mientras que ASCII usa 7 bits para codificar cualquier carácter porque consta de solo 128 caracteres.

- Unicode ocupa un espacio más grande porque es el superconjunto de ASCII, mientras que ASCII requiere menos espacio.

Conclusión

Unicode o el juego de caracteres universal es el estándar de codificación que codifica, representa y maneja textos para los servicios de telecomunicaciones y otros equipos, mientras que ASCII o el código estándar americano para el intercambio de información es el código estándar que se utiliza para la codificación en la comunicación electrónica.

Unicode cubre la codificación de los textos en diferentes idiomas (incluso aquellos con escrituras bidireccionales como hebreo y árabe), de símbolos, escrituras matemáticas e históricas, etc., mientras que ASCII cubre la codificación de caracteres del idioma inglés que incluye la letra mayúscula (AZ) , las letras minúsculas (az), dígitos (0-9) y símbolos como signos de puntuación.

Unicode utiliza tres tipos de codificación, a saber, la de 8 bits, 16 bits y 32 bits, mientras que ASCII opera utilizando 7 bits para representar cualquier carácter. Por lo tanto, Unicode también es el superconjunto de ASCII y ocupa más espacio que él.

Nube de palabras para diferenciar entre Unicode y ASCII

La siguiente es una recopilación de los términos más utilizados en este artículo sobre Unicode y ASCII. Esto debería ayudar a recordar términos relacionados tal como se utilizan en este artículo en una etapa posterior.

Referencias

Intente el cuestionario de TI